文 : 陳思宏 (轉載請註明出處)

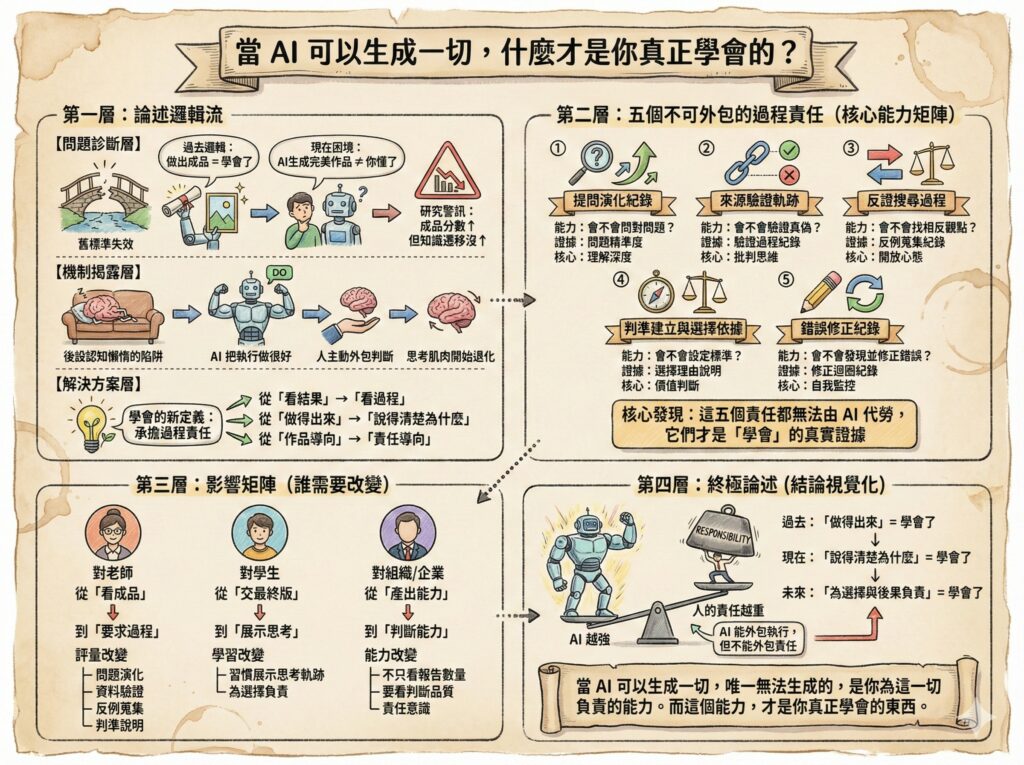

AI能生成完美作品,卻不等於你懂。研究指出:作品表現提升不必然帶來知識遷移,也可能導致「後設認知懶惰」。本文提出「學會=承擔過程責任」:提問演化、來源驗證、反證搜尋、判準建立、錯誤修正。

打破「有圖有真相」的迷思

以往我們被教導:「有圖有真相」、「拿出證據來」、「做得出來就代表你會」。這套邏輯支撐了整個教育評量系統——交出一份報告、完成一個專案、寫出一篇文章,這些「作品」就是你學會的證明。

但AI徹底打破了這個假設。

現在,一個從沒碰過Python的學生,可以用ChatGPT生成一段完整的程式碼;一個英文不好的人,可以讓AI寫出語法完美、結構清晰的論文。照片可以生成、影片可以偽造,連思考過程的「草稿演化」都可以請AI模擬出來。

當AI可以生成完美的作品,「作品」還能證明什麼?

研究已經給出殘酷的答案:成品變好,不等於你學會了。多項研究發現,使用ChatGPT的學生作品分數確實提升,但在知識獲得、概念遷移等指標上並沒有同步進步。更值得警惕的是,研究者明確指出一種新風險:後設認知懶惰(metacognitive laziness)——當學生把評估、驗證、統整與判斷也一起交給AI,他們的思考肌肉就開始退化。

這不是說AI不好,而是我們用錯了標準來定義「學會」。

我們到底在學什麼?

過去,我們習慣把「學習」等同於「做出東西」。寫出一篇報告、算出一道題目、設計出一個方案——這些產出就是能力的證明。

但AI時代逼我們面對一個更根本的問題:你到底是學會「做」,還是學會「判斷什麼值得做、如何做對」?

AI非常擅長執行。給它指令,它可以寫、可以算、可以生成。但它無法替你回答:

- 這個問題值得解決嗎?

- 什麼叫做「好的答案」?

- 這個資料可信嗎?

- 在這三個方案中,我該選哪個?為什麼?

這些「為什麼這樣做」的判斷,必須由人來承擔。

問題是,當AI把執行做得越來越好,很多人開始把判斷也一起外包。研究觀察到,學生花更少時間確認任務要求、評估文本品質,甚至傾向直接複製貼上AI生成的內容,而不去檢查它是否正確、是否適合、是否真的回答了問題。

這才是真正的危機:不是AI會取代人,而是人主動放棄了思考的責任。

學會的新定義:承擔過程責任

如果「做出成品」不再能證明學會,那什麼可以?

答案是:你能不能說清楚「我為什麼這樣做」,並且提供過程證據。

過去我們看結果,現在我們要看過程。具體來說,有五個「不可外包的過程責任」,這些才是真正的思考肌肉訓練:

-

提問演化紀錄

能力:你會不會問對問題?

AI只能回答你的問題,但「問對問題」是你的責任。真正的學習發生在:你最初問了什麼?AI給的答案哪裡不對?你如何修正問題?

例如,寫報告時,如果你只問「幫我寫一段關於氣候變遷的內容」,AI會給你通用的敘述。但如果你問「氣候變遷對台灣農業的影響,特別是稻米產量,過去十年的數據顯示什麼趨勢?」這個問題的精準度,就反映了你對主題的理解深度。

-

來源驗證軌跡

能力:你會不會驗證真偽?

AI會編造資料、引用不存在的文獻、給出過時的數字。你的責任是查證:AI引用的每一個數據、每一個來源,哪些是對的?哪些有問題?你如何修正?[

例如,AI告訴你「根據2023年研究,XX%的人使用社群媒體超過五小時」,你去找這個研究了嗎?它真的存在嗎?樣本數多少?是哪個國家的數據?這些驗證步驟只有你能完成。

-

反證搜尋過程

能力:你會不會主動尋找相反觀點?

AI傾向給你「聽起來合理」的答案,但你的責任是主動去找反例、找相反的研究、找不同的詮釋角度。

例如,如果AI說「遠距工作提升生產力」,你去找過「遠距工作降低生產力」的研究嗎?兩邊的證據各是什麼?你最後為何選擇某一邊的論點?這個過程證明你不是被動接受,而是主動建構理解。

-

判準建立與選擇依據

能力:你會不會設定標準並做取捨?

當AI給你三個方案,你選了哪個?為什麼?你用什麼標準判斷「這個比較好」?

例如,AI幫你生成三種行銷文案,你選了第二個。為什麼?是因為語氣更符合品牌調性?還是更能打動目標受眾?如果你說不清楚,那你其實沒有真正做出判斷,只是隨機選了一個。

-

錯誤修正紀錄

能力:你會不會發現錯誤並修正?

AI第一次給的答案通常不完美。你怎麼發現問題的?用什麼邏輯判斷它錯了?如何修正?

例如,AI幫你算一個數學應用題,答案是120。但你代入情境後發現不合理(例如人數不可能是小數),你重新檢查運算邏輯,發現AI理解錯了題意。這個「發現—判斷—修正」的迴圈,就是學習真正發生的地方。

這五個過程責任,是這個時代的重要任務,也是驗證我們「學會」的真實證據。

這對老師、學生、組織意味著什麼?

如果我們接受「學會=承擔過程責任」這個新定義,整個教育與工作的評量邏輯都要改變。

對老師:從「看成品」到「要求過程證據」

不能再只收一份最終報告,而是要求學生提交:

- 你問了哪些問題?如何演化?

- 你驗證了哪些資料?哪些是錯的?

- 你找過反例嗎?為什麼最後沒採納?

- 你的判斷標準是什麼?

這不是為難學生,而是把評量重心從「產出」拉回「思考」。

對學生:習慣「展示思考軌跡」而非只交最終版

這可能會不習慣。過去你只要交出一份「看起來很好」的作品就能拿分數,現在你必須證明:這個作品的每一個判斷、每一個選擇,你都能說清楚為什麼。

但這才是真正對你有益的訓練。因為未來,AI會越來越會「做」,但只有你能為這個「做」負責。

對組織/企業:從「產出能力」到「判斷能力」

很多公司現在鼓勵員工用AI提升效率,這沒有錯。但如果只看產出(報告寫得快、提案做得多),而不檢視判斷品質(這個方案為什麼選這個?數據驗證過嗎?風險評估了嗎?),那你培養的是一群「會用工具但不會思考」的人。

當AI越普及,真正稀缺的能力是:在AI生成的三個方案中,知道該選哪個、為什麼選、以及如何為這個選擇負責。

AI越強,人的責任越重

AI可以外包執行,但不能外包責任。

當你說「這是我的作品」、「這是我的決策」、「這是我的報告」,你必須能夠回答:我為什麼這樣做?我用什麼標準判斷這樣是對的?我驗證過哪些資訊?排除過哪些可能性?

過去,「學會」的定義是「做得出來」。

現在,「學會」的定義是「說得清楚為什麼這樣做」。

這不是在否定AI的價值,而是在提醒我們:AI可以讓我們做得更快、更好,但它不能替我們承擔「為什麼」的責任。

當AI可以生成一切,唯一無法生成的,是你為這一切負責的能力。

而這個能力,才是你真正學會的東西。

#生成式AI #AI教育#學習科學 #後設認知 #批判思考 #知識遷移 #認知卸載 #自我導向學習 #教學設計 #AI素養 #教育科技 #Metacognition